祝贺实验室博士研究生颜鲲同学论文被计算机视觉顶会CVPR2023接收

近日,北京大学智能计算与感知实验实验室博士研究生颜鲲同学再度传来喜讯,他以第一作者投稿的“Two-shot Video Object Segmentation”的论文被被计算机视觉领域三大顶会之一的CVPR 2023录用,论文指导老师为智能计算与感知实验室主任王平教授。

视频物体分割指的是根据视频的第一帧给出的目标物体的分割标注,将该视频剩余的帧中包含的目标物体全部分割出来,是

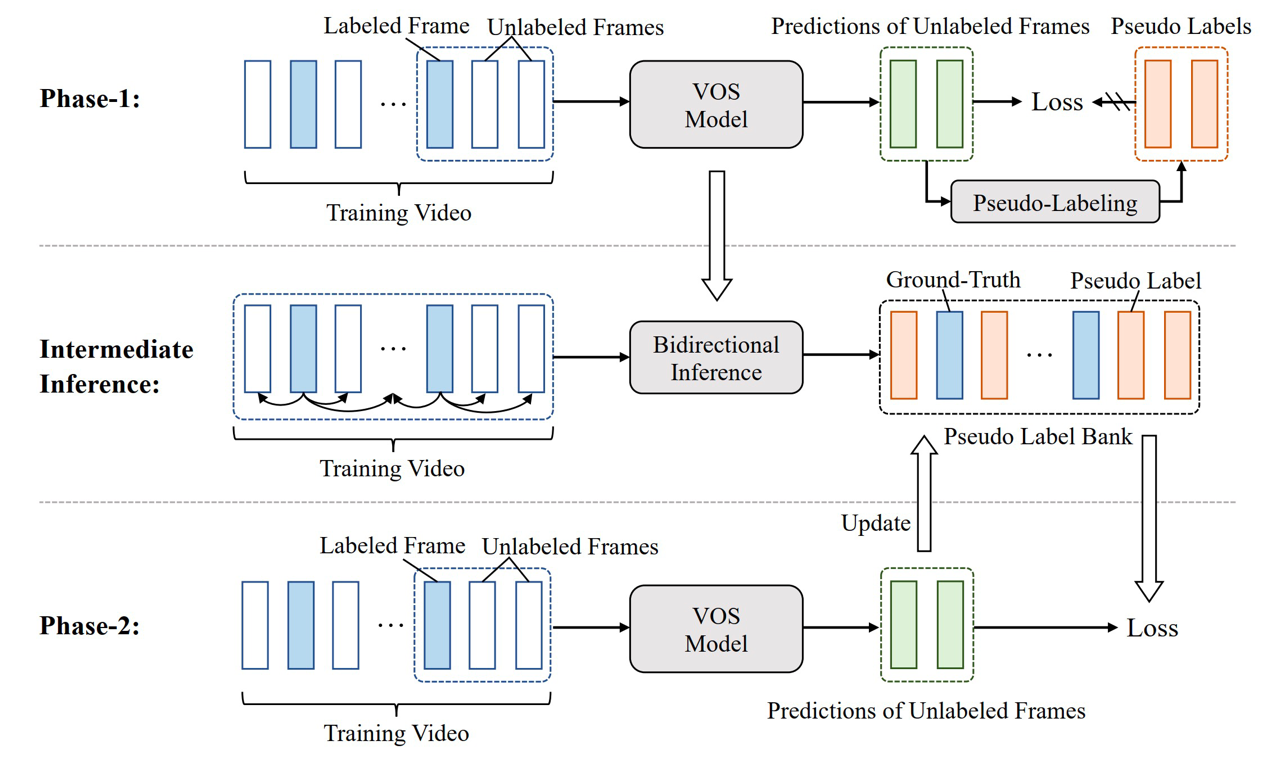

众多视频理解任务(如视频监测、自动驾驶等)的基础。然而,尽管当前的VOS模型已经在公开数据集上达到了较高的分割精度,但依赖于视频帧的密集标注,这是既费时又费力的。本文工作发现STCN模型在每个视频只标注2帧(2-shot)的情况下依然可以获得不错的分割结果(相比全标注训练的精度在YouTube-VOS数据集上相差了2.1%),但有大量的无标签数据没有被利用到。因此,基于以上发现,本文基于2-shot VOS任务提出了一种可为无标签帧高效生成伪标签两阶段训练方法,并能够泛化到若干VOS方法使其达到跟全标注训练下相当的精度,比如对于STCN模型,可以使其在2-shot VOS任务(在数据集YouTube-VOS和DAVIS分别减少92.7%和97.1%标注量)下分别在YouTube-VOS 2019和DAVIS 2017数据集上获得85.1%和82.7%的精度,对比STCN模型在全标注情况下的精度85.2%和82.7%,性能上只有0.1%和0.0%的差距。本篇论文第一次证明了每个视频只需要标注两帧就可以进行有效的VOS任务学习的可能性,不再依赖全标注数据,为之后VOS任务的研究提供了新的方向。

众多视频理解任务(如视频监测、自动驾驶等)的基础。然而,尽管当前的VOS模型已经在公开数据集上达到了较高的分割精度,但依赖于视频帧的密集标注,这是既费时又费力的。本文工作发现STCN模型在每个视频只标注2帧(2-shot)的情况下依然可以获得不错的分割结果(相比全标注训练的精度在YouTube-VOS数据集上相差了2.1%),但有大量的无标签数据没有被利用到。因此,基于以上发现,本文基于2-shot VOS任务提出了一种可为无标签帧高效生成伪标签两阶段训练方法,并能够泛化到若干VOS方法使其达到跟全标注训练下相当的精度,比如对于STCN模型,可以使其在2-shot VOS任务(在数据集YouTube-VOS和DAVIS分别减少92.7%和97.1%标注量)下分别在YouTube-VOS 2019和DAVIS 2017数据集上获得85.1%和82.7%的精度,对比STCN模型在全标注情况下的精度85.2%和82.7%,性能上只有0.1%和0.0%的差距。本篇论文第一次证明了每个视频只需要标注两帧就可以进行有效的VOS任务学习的可能性,不再依赖全标注数据,为之后VOS任务的研究提供了新的方向。

【CVPR是计算机学科普遍认可的计算机视觉领域顶级国际会议,被中国计算机学会(CCF)列为A类会议,其录用论文指引着计算机视觉领域未来的研究方向,今年论文录用率为25%左右。根据权威的Google Scholar Citation统计,CVPR排在所有学科目录第4位(Nature第1位,Science第3位),排在工程与计算机学科榜单第1位。】